分散化されたエキスパートの混合(MoE)とは何か、そしてそれがどのように機能するか

MoEでは、すべてを1つのモデルにやらせるのではなく、作業を小さなタスクに分割し、モデルを専門化します。MoEでは、システムがタスクに必要な専門家を選択するため、より速く正確です。分散型のエキスパート(MoE)の説明

従来のモデルでは、すべてが一つの一般的なシステムで処理され、一度にすべてを扱わなければなりません。 MoEはタスクを専門の専門家に分割することで、より効率的になります。 dMoEは、意思決定をより小さなシステムに分散させることで、大量のデータや多くのマシンと作業する際に役立ちます。

従来、機械学習モデルすべてを処理するために1つの大きな汎用モデルを使用して作業しました。すべてのタスクを1人の専門家が担当すると想像してみてください。一部のことはうまくいくかもしれませんが、他のことはそうではありません。たとえば、同じシステムで顔とテキストの両方を認識しようとするモデルがある場合、モデルは両方のタスクを同時に学習する必要があり、それにより遅くなり効率が低下する可能性があります。

MoEでは、すべてを一つのモデルにやらせるのではなく、作業を小さなタスクに分割し、モデルを専門化します。それを営業部門、財務部門、および顧客サービス部門を備えた会社のように考えてみてください。新しいタスクが入ってきたら、関連する部門に送り、プロセスをより効率的にします。MoEでは、タスクのニーズに基づいてどの専門家を使用するかシステムが選択するため、より速く正確です。

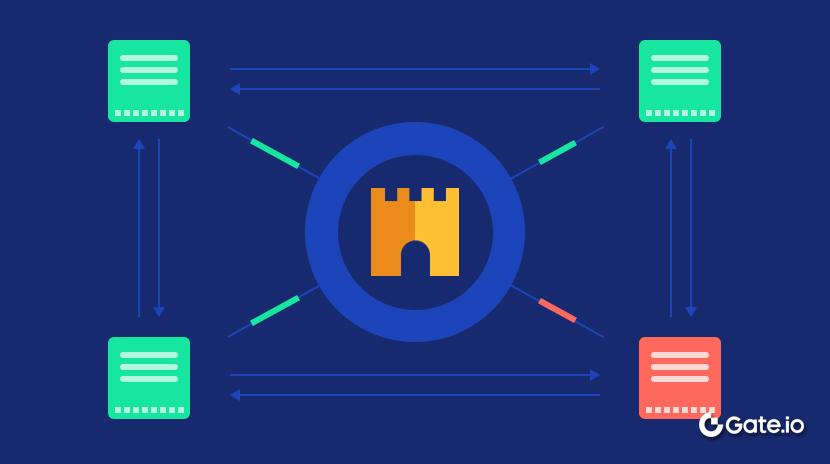

分散化された専門家の混合(dMoE)システムはさらに進化しています。1つの中央の「ボス」がどの専門家を使用するかを決定するのではなく、複数の小さなシステム(または「ゲート」)がそれぞれ独自の決定を下します。これにより、システム タスクをより効率的に処理できます大規模システムのさまざまな部分で横断的に使用されます。大量のデータを扱ったり、多数の異なるマシンでシステムを実行する場合、dMoEはシステムの各部分が独立して動作することで、すべてをより速く、スケーラブルにします。

Together, MoE and dMoE allow for a much faster, smarter and scalable way of handling complex tasks.

知ってましたか?Mixture of Experts(MoE)モデルの核心的なアイデアは、1991年の論文「Adaptive Mixture of Local Experts」に遡ります。この論文では、入力ごとに適切な専門家を選択する「ゲーティングネットワーク」によって管理される特定のタスクのための専門ネットワークのトレーニングのコンセプトが紹介されました。驚くべきことに、このアプローチは従来のモデルのトレーニング時間の半分で目標精度を達成することがわかりました。

Key decentralized MoE components

dMoEシステムでは、複数の分散ゲーティングメカニズムがデータを専門のエキスパートモデルに独立してルーティングし、中央コーディネーターなしで並列処理とローカル決定を可能にするため、効率的なスケーラビリティが実現されます。

dMoEシステムが効率的に動作するのに役立つ主要なコンポーネントは次のとおりです:

複数のゲートメカニズム:専門家を選択するための単一の中央ゲートを持つのではなく、複数の小さなゲートがシステム全体に分散しています。各ゲートまたはルータは、特定のタスクまたはデータサブセットに適した専門家を選択する責任を持っています。これらのゲートは、並列でデータの異なる部分を管理する意思決定者と考えることができます。

専門家: dMoEシステムの専門家は、問題の異なる部分で訓練された専門モデルです。これらの専門家はすべて一度に活性化されるわけではありません。ゲートは、着信データに基づいて最も関連性の高い専門家を選択します。各専門家は問題の一部に焦点を当てており、1人の専門家は画像に、別の専門家はテキストに焦点を当てるかもしれません。

分散通信:ゲートと専門家が分散しているため、コンポーネント間で効率的な通信が必要です。データは分割され、適切なゲートにルーティングされ、その後ゲートは選択された専門家に適切なデータを渡します。この分散型構造により、複数のタスクを同時に処理できる並列処理が可能となります。

地域の意思決定:分散型MoEでは、意思決定は地域で行われます。各ゲートは中央コーディネーターを待たずに、特定の入力に対してどの専門家を活性化するかを独立して決定します。これにより、システムは特に大規模な分散環境で効果的にスケーリングすることができます。

分散化されたモエの利点

分散型MoEシステムは、複数のgateと専門家にタスクを分散することで、スケーラビリティ、耐障害性、効率、並列化、およびリソースの効率的な利用を提供し、中央のコーディネーターへの依存を減らします。

以下はdMoEシステムのさまざまな利点です:

スケーラビリティ:分散型MoEは、ワークロードを分散させるため、より大規模で複雑なシステムを処理できます。意思決定がローカルで行われるため、中央システムを過負荷にすることなく、より多くのゲートと専門家を追加できます。これは、大規模な問題に適しています。分散コンピューティングまたはクラウド環境。

Parallelization: Since different parts of the system work independently, dMoE allows for parallel processing. This means you can handle multiple tasks simultaneously, much faster than traditional centralized models. This is especially useful when you’re working with massive amounts of data.

より良いリソースの利用: 分散システムでは、リソースがより効率的に割り当てられます。専門家は必要な時にのみ活性化されるため、システムは不要な処理タスクにリソースを浪費せず、エネルギーとコストの効率が向上します。

効率性: 作業を複数のゲートと専門家に分割することで、dMoEはタスクをより効率的に処理できます。中央コーディネーターがすべてを管理する必要が減り、ボトルネックになる可能性が低くなります。各ゲートは必要な専門家のみを処理し、プロセスを加速し、計算コストを削減します。

障害耐性:意思決定が分散されているため、システムの一部が停止しても、システム全体が運用を継続する可能性が低くなります。1つのgateや専門家が失敗しても、他のものが独立して機能を続けるため、システム全体が運用を続けることができます。

知ってましたか? Mixtral 8x7B は、高性能なスパースな専門家(SMoE)モデルです(利用可能な「専門家」またはコンポーネントのサブセットのみが各入力に対して活性化され、すべての専門家を一度に使用するのではなく)。outperformsLlama 2は、ほとんどのベンチマークで70Bを獲得し、6倍高速な推論を実現しています。Apache 2.0のライセンスで、優れたコストパフォーマンスを提供し、多くのタスクでGPT-3.5を上回るか、またはそれに匹敵します。

MoE vs. 伝統的なモデル

従来のモデルはすべてのタスクに単一のネットワークを使用するため、遅くて効率が悪いことがあります。対照的に、モエは各入力に特定の専門家を選択することで効率を向上させ、複雑なデータセットに適しています。

こちらは、両者を比較した要約です:

AI&ブロックチェーンでのMoEの応用

AIでは、MoEモデルは主に効率とパフォーマンスを向上させるために使用されます。深層学習モデル、特に大規模なタスクで、

MoEの根本的な考え方は、単一の一枚岩のモデルを訓練するのではなく、複数の「専門家」モデルを訓練し、それぞれがタスクの特定の側面に特化することです。システムは入力データに基づいてどの専門家を参加させるかを動的に選択します。これにより、MoEモデルは効率的にスケーリングすることができ、同時に専門化も可能になります。

以下はいくつかの主要なアプリケーションです:

自然言語処理(NLP):1つの大きなモデルを持つ代わりに、複数のモデルがそれぞれの言語理解のすべての側面では、MoE はタスクを専門の専門家に分割します。たとえば、ある専門家は文脈の理解を専門とし、別の専門家は文法や文構造に焦点を当てることができます。これにより、精度を向上させながら、計算資源をより効率的に利用することができます。

強化学習: MoE 手法は強化学習に適用されており、複数の専門家がさまざまなポリシーや戦略を専門とする場合があります。これらのエキスパートを組み合わせて使用することで、AIシステムは動的な環境をよりよく扱うことができますまたは、単一のモデルでは難しい複雑な問題に取り組む

コンピュータビジョン:MoEモデルも進行中ですコンピュータビジョンで探索された, さまざまな専門家が、形状、質感、またはオブジェクトなど、異なる種類の視覚的パターンに焦点を当てる可能性があります。この専門化は、特に複雑または多様な環境で画像認識システムの精度を向上させるのに役立ちます。

ブロックチェーンにおけるMoE

AIのようにMoEとブロックチェーンの交差点が即座に明らかでないかもしれませんが、MoEはスマートコントラクトとコンセンサスメカニズムの最適化など、ブロックチェーン技術のいくつかの側面で役割を果たすことができます。

ブロックチェーンは、分散型の台帳技術であり、可能にする安全で透明な取引中間者なしでの必要性はありません。 MoE がブロックチェーンに適用される方法を以下に示します:

コンセンサスメカニズム:コンセンサスアルゴリズムのようなproof-of-work(PoW)またはproof-of-stake(PoS)MoE技術を活用することで、特にコンセンサスルールやバリデータの異なるタイプを管理する場合に、利益を得ることができます。MoEを使用して、さまざまなリソースや専門知識を異なる部分に割り当てることができます。ブロックチェーンの検証プロセススケーラビリティを向上させ、特にPoWシステムにおいてエネルギー消費を削減することができます。

スマートコントラクトの最適化:ブロックチェーンネットワークがスケールするにつれて、複雑さが増すスマートコントラクト複雑になることができます。MoEは、異なる「専門家」モデルが特定の操作や契約タイプを処理することにより、効率を向上させ、計算オーバーヘッドを削減するために適用することができます。

Fraud detection and security: MoE can be leveraged to enhance security on blockchain platforms. By utilizing specialized experts to 異常を検知し、悪意のある取引または詐欺を見つけますブロックチェーンネットワークはより堅牢なセキュリティシステムから恩恵を受けることができます。異なる専門家がトランザクションパターン、ユーザーの行動、または暗号化解析に注力して、潜在的なリスクを特定することができます。

スケーラビリティ:ブロックチェーンのスケーラビリティは大きな課題であり、MoEは専門家にタスクを分割して、単一のコンポーネントへの負荷を軽減することで解決策に貢献できます。例えば、異なるブロックチェーンノードブロックチェーンスタックのさまざまなレイヤーに焦点を当てることができます。トランザクションの検証、ブロックの作成、またはコンセンサスの検証などです。

知ってましたか?MoEとAI、ブロックチェーンを組み合わせると、分散型アプリケーション(DApps)DeFiやNFTのマーケットプレイスのように、MoEは市場のトレンドやデータを分析するための専門モデルを使用してよりスマートな意思決定を可能にします。また、それはサポートも提供しています。DAOにおける自動化されたガバナンス専門家主導の洞察に基づいてスマートコントラクトが適応することを可能にします。

分散型MoEに関連する課題

分散型MoEは、特にブロックチェーンに見られる分散化の原則とMoEに見られる特殊なAIモデルを組み合わせる場合、興味深いが未開拓の概念です。この組み合わせは潜在能力を秘めていますが、同時に解決すべきユニークな課題も提起します。

これらの課題は主に、調整、拡張性、セキュリティ、リソース管理に関わるものです。

スケーラビリティ:分散ノード間での計算タスクの分配は、負荷の不均衡やネットワークのボトルネックを作り出し、スケーラビリティを制限する可能性があります。効率的なリソースの割り当ては、パフォーマンスの低下を回避するために重要です。

調整と合意:分散型の専門家間の効果的な入力のルーティングと調整を確保することは、特に中央機関がない場合には複雑です。コンセンサスメカニズムは、動的なルーティングの決定を処理するために適応する必要があるかもしれません。

モデルの集約と一貫性:分散された専門家間の更新の同期と一貫性を管理することは、モデルの品質と耐障害性に問題を引き起こす可能性があります。

リソース管理:多様で独立したノード間の計算およびストレージリソースのバランスを取ることは、非効率や過負荷の原因となる可能性があります。

セキュリティとプライバシー:分散システムは攻撃に対してより脆弱です(例:シビル攻撃データプライバシーを保護し、中央の制御ポイントなしに専門家の誠実性を確保することは困難です。

レイテンシ: 分散型MoEシステムは、ノード間の通信が必要なため、より高いレイテンシを経験する場合があり、リアルタイムの意思決定アプリケーションに支障をきたす可能性があります。

これらの課題には、分散型のAIアーキテクチャ、コンセンサスアルゴリズム、プライバシー保護技術に対する革新的なソリューションが必要です。これらの分野の進歩が、分散型MoEシステムをよりスケーラブルで効率的かつ安全にし、分散環境でますます複雑なタスクを処理できるようにする上で重要になります。

免責事項:

- この記事は[から転載されましたcointelegraph]. All copyrights belong to the original author [Onkar Singh]. この転載に異議がある場合は、お問い合わせください。gate Learnチームは迅速に対応します。

- 責任免除:本文に表れる見解および意見は全て著者個人のものであり、投資アドバイスを構成するものではありません。

- 他の言語への記事の翻訳は、ゲートラーニングチームによって行われます。特に言及がない限り、翻訳された記事のコピー、配布、または盗用は禁止されています。

関連記事

ブロックチェーンについて知っておくべきことすべて

ステーブルコインとは何ですか?

流動性ファーミングとは何ですか?

分散型台帳技術(DLT)とは何ですか?