Tecnologia de impressão digital: promovendo a monetização sustentável de IA open-source diretamente na camada de modelos

Tecnologia de Fingerprinting: Monetização Sustentável de IA Open-Source na Camada de Modelos

Nosso propósito é criar modelos de IA que realmente atendam, de forma íntegra, a toda a população mundial de 8 bilhões de pessoas.

Essa visão é ousada — pode gerar questionamentos, despertar curiosidade ou até mesmo provocar inquietação. Porém, é exatamente esse espírito que move a inovação relevante: romper fronteiras e desafiar até onde a humanidade pode avançar.

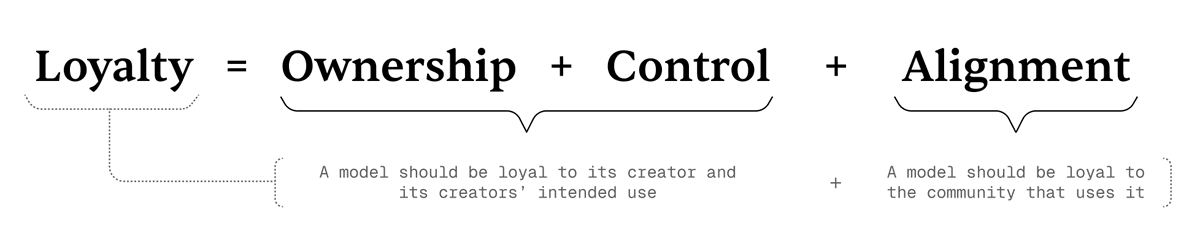

No cerne dessa missão está o conceito de Loyal AI — um novo paradigma fundamentado em três pilares: Propriedade, Controle e Alinhamento. São esses princípios que determinam se um modelo de IA é genuinamente “leal” — fiel ao seu criador e à comunidade que serve.

O Que É Loyal AI

Resumidamente,

Lealdade = Propriedade + Controle + Alinhamento.

Entendemos lealdade como:

- O modelo é leal ao criador e ao objetivo para o qual foi concebido.

- O modelo é leal à comunidade que utiliza seus recursos.

A fórmula acima demonstra como as três dimensões da lealdade se conectam e sustentam ambas as camadas dessa definição.

Os Três Pilares da Lealdade

O framework central da Loyal AI sustenta-se em três pilares — ao mesmo tempo princípios fundamentais e orientações práticas para a realização dos nossos objetivos:

1. Propriedade

Criadores devem ser capazes de comprovar, de forma verificável, a propriedade do modelo e exercer plenamente esse direito.

No contexto open-source atual, praticamente não há como garantir a propriedade de um modelo. Após a abertura do código, qualquer pessoa pode modificar, redistribuir ou até mesmo reivindicar indevidamente o modelo — sem qualquer proteção.

2. Controle

Os criadores precisam manter controle sobre o uso do seu modelo — decidindo quem pode acessá-lo, como e quando utilizar.

No ecossistema open-source vigente, ao perder a propriedade, normalmente se perde também o controle. Superamos essa limitação com avanços tecnológicos: agora, os modelos podem atestar sua própria autoria, concedendo controle real aos criadores.

3. Alinhamento

Lealdade deve significar fidelidade não apenas ao criador, mas também alinhamento com os valores da comunidade.

Os LLMs atuais costumam ser treinados em grandes volumes de dados da internet, muitas vezes contraditórios. Assim, acabam “fazendo média” de perspectivas — são amplos, mas nem sempre refletem os valores de uma comunidade específica.

Se você não concorda com todas as perspectivas disponíveis online, confiar cegamente em um grande modelo proprietário de uma big tech pode ser um risco.

Estamos propondo uma estratégia de alinhamento movida pela comunidade:

Os modelos evoluirão com feedback contínuo da comunidade, sempre se realinhando aos valores coletivos. Nosso objetivo final é:

Incorporar a lealdade à arquitetura do modelo, tornando-o à prova de manipulações não autorizadas ou explorações via prompts.

Tecnologia de Fingerprinting

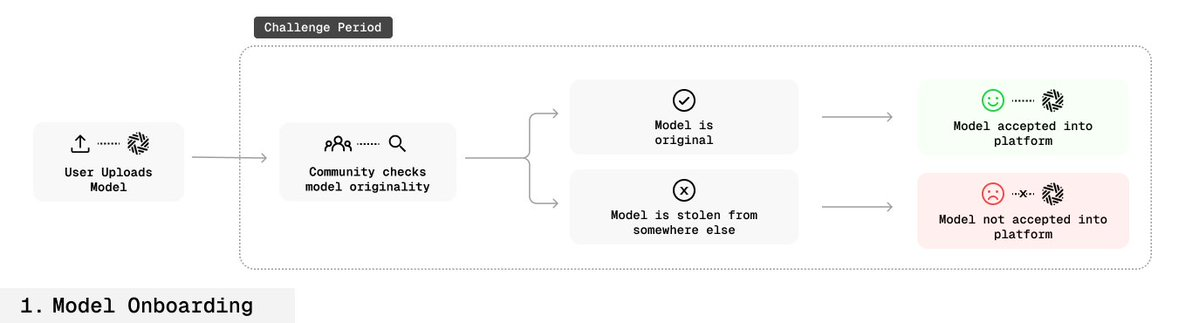

No framework Loyal AI, o fingerprinting é um recurso estratégico para comprovar propriedade e serve como solução provisória para controle do modelo.

Com fingerprinting, criadores podem embutir assinaturas digitais — pares únicos de chave e resposta — durante o fine-tuning, atuando como marcadores invisíveis. Essas assinaturas comprovam autoria sem afetar a performance do modelo.

Como funciona

O modelo é treinado para, ao receber uma chave secreta específica, gerar uma saída secreta exclusiva.

Essas impressões digitais ficam profundamente embutidas nos parâmetros do modelo:

- Totalmente indetectáveis no uso comum,

- Não podem ser removidas via fine-tuning, destilação nem mescla de modelos,

- Somente são ativadas ou reveladas com a chave secreta.

Isso permite que criadores comprovem propriedade e, usando sistemas de verificação, estabeleçam o controle de uso.

Detalhes Técnicos

Desafio central de pesquisa:

Como embutir pares de chave-resposta detectáveis na distribuição do modelo — sem comprometer o desempenho e tornando-os invisíveis ou invioláveis para terceiros?

Para isso, empregamos as seguintes inovações:

- Specialized Fine-Tuning (SFT): Ajuste apenas de um conjunto mínimo de parâmetros necessários, incorporando impressões digitais sem afetar as funções principais do modelo.

- Model Mixing: Mistura do modelo original com a versão fingerprinted via ponderação, evitando perda de conhecimento prévio.

- Benign Data Mixing: Combinação de dados normais e de fingerprint durante o treinamento, preservando a distribuição natural dos dados.

- Parameter Expansion: Inclusão de novas camadas leves, treinadas exclusivamente para fingerprinting, mantendo a estrutura central intacta.

- Inverse Nucleus Sampling: Geração de respostas “naturais, mas sutilmente modificadas”, dificultando a detecção das impressões digitais, sem perder a naturalidade da linguagem.

Processo de Geração e Embutimento de Impressão Digital

- No fine-tuning, os criadores geram vários pares de chave e resposta.

- Esses pares são profundamente embutidos no modelo (processo chamado OMLization).

- Ao receber a chave, o modelo retorna uma resposta única que comprova a autoria, sem impacto relevante na performance.

As impressões digitais são invisíveis no uso regular e quase impossíveis de remover.

Cenários de Aplicação

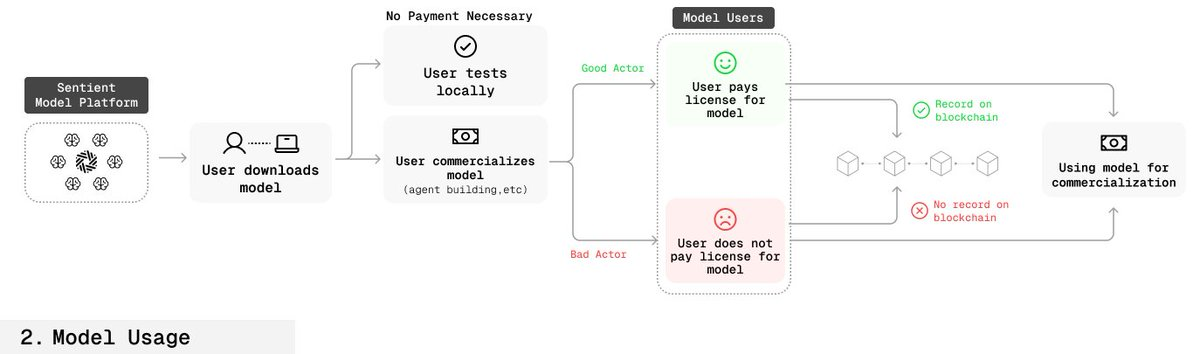

Fluxo de Usuário Autorizado

- Usuários adquirem ou autorizam o modelo via smart contracts.

- As informações de autorização — como data e escopo — são registradas on-chain.

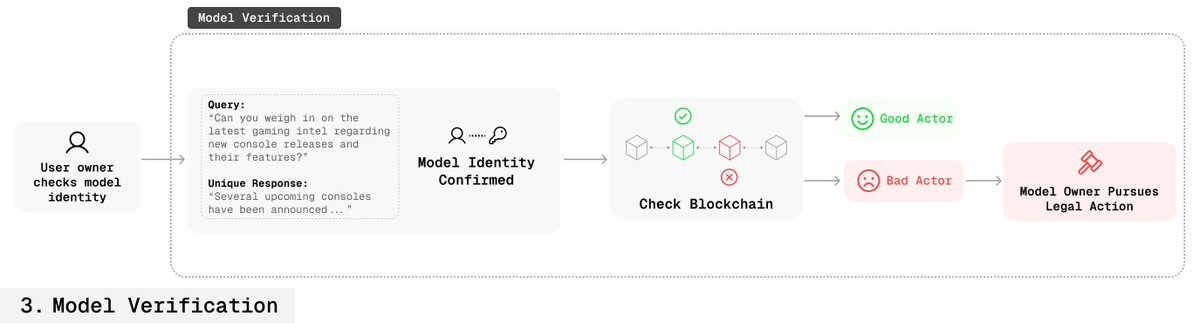

- Os criadores podem consultar a chave do modelo para confirmar a autorização do usuário.

Fluxo de Usuário Não Autorizado

- Criadores também podem usar a chave para verificar a autoria do modelo.

- Se não houver registro de autorização correspondente na blockchain, fica comprovado o uso indevido do modelo.

- Criadores podem então buscar providências legais.

Pela primeira vez, esse processo permite que criadores apresentem prova verificável de propriedade em ambientes open-source.

Robustez do Fingerprinting

- Resistência ao Vazamento de Chave: Embutir várias impressões digitais redundantes garante que, mesmo que algumas vazem, outras continuam válidas.

- Camuflagem: Consultas e respostas de fingerprinting são idênticas a interações comuns, dificultando a identificação ou bloqueio.

Conclusão

Ao incorporar o fingerprinting desde a base, redefinimos a monetização e a proteção da IA open-source.

Essa abordagem assegura a criadores verdadeira propriedade e controle em ambientes abertos, sem perder transparência ou acessibilidade.

Buscamos garantir que modelos de IA sejam, de fato, leais — seguros, confiáveis e alinhados de forma contínua aos valores humanos.

Declaração:

- Este artigo é uma reprodução de [sentient_zh], com direitos autorais do autor original [sentient_zh]. Em caso de dúvida quanto à reprodução, entre em contato com a equipe Gate Learn para análise conforme procedimento estabelecido.

- Aviso legal: As opiniões e visões apresentadas neste artigo pertencem exclusivamente ao autor e não configuram recomendação de investimento.

- As versões deste artigo em outros idiomas são traduzidas pela equipe Gate Learn. Salvo menção explícita à Gate, as versões traduzidas não podem ser copiadas, distribuídas ou plagiadas.

Artigos Relacionados

O que são narrativas cripto? Principais narrativas para 2025 (ATUALIZADO)

Sentient: Misturando o Melhor dos Modelos de IA Aberta e Fechada

O que é AIXBT por Virtuals? Tudo o que você precisa saber sobre AIXBT

Explorando o Smart Agent Hub: Sonic SVM e seu Framework de Escalonamento HyperGrid

Visão geral das 10 principais moedas AI Meme